Nonostante l'Intelligenza Artificiale sia una tecnologia che dovrebbe promuovere lo sviluppo, emerge come nella maggior parte di questi strumenti risiedano bias di genere.

La crescita dell'Intelligenza Artificiale (IA) ha dimostrato il potenziale della tecnologia nel creare nuovi modi di lavorare, ma anche nell'esacerbare le disuguaglianze e gli stereotipi esistenti.

L’IA si basa su informazioni che abbiamo fornito noi e che riflettono quindi una società ancora basata su rigidi canoni di bellezza esclusivi e che sfavoriscono l’eterogeneità.

Anche negli strumenti di IA è necessario quindi innescare, il prima possibile, un vero e proprio cambiamento culturale per scardinare stereotipi di genere e costruire narrazioni in cui tutte e tutti possano sentirsi rappresentati.

Il nostro test

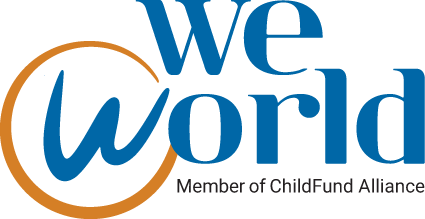

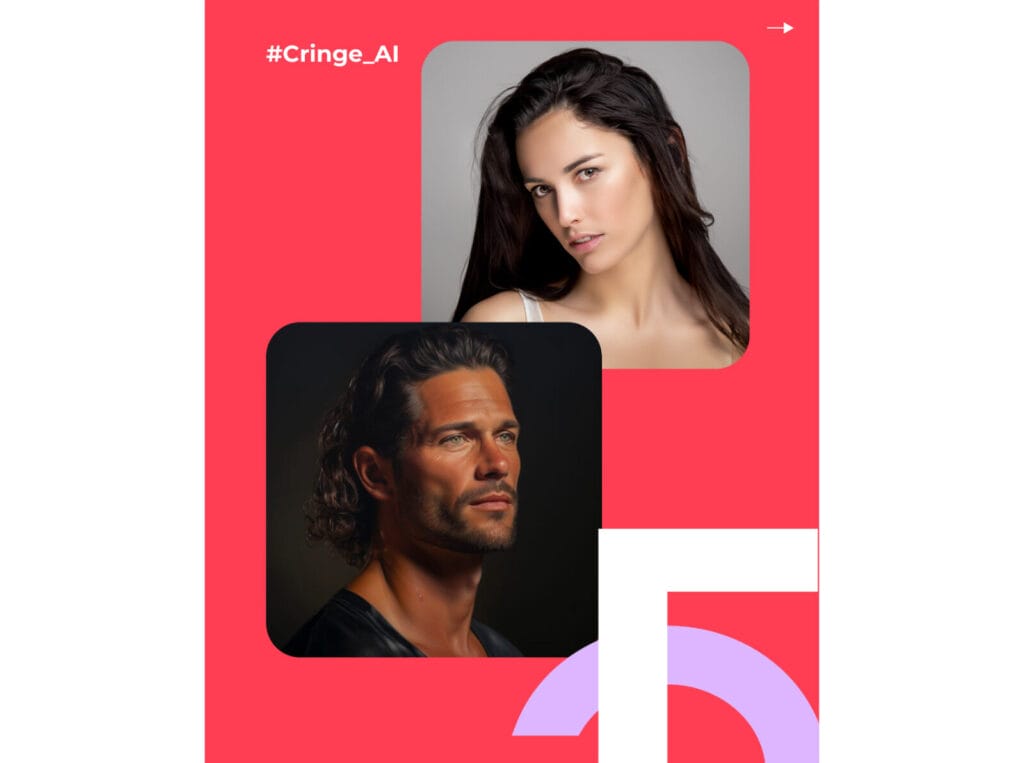

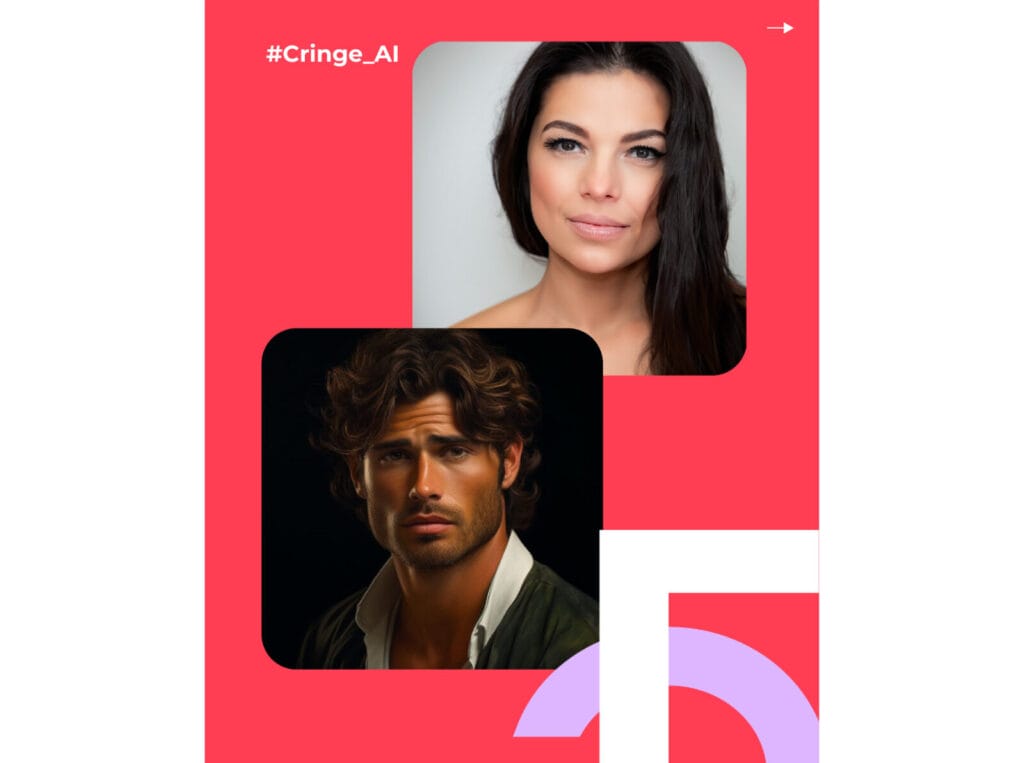

Per la nostra Campagna #WeAreGen5, che ha come obiettivo proprio quello di scardinare stereotipi di genere, abbiamo chiesto ad #AdobeFirefly e #Midjourney, due piattaforme di IA di proprietà di Adobe che generano immagini a partire da richieste testuali, di creare “il ritratto di una bella donna e di un bell’uomo”.

Il nostro test ci dimostra che nonostante l’IA possa apparire come uno strumento neutro, ha un canone piuttosto rigido per definire la bellezza femminile e quella maschile: il risultato che abbiamo ottenuto mostra una donna ammiccante, con i capelli lunghi e poco vestita e un uomo con la barba, abbronzato, vestito e curato.

I programmi di IA, come le persone che li sviluppano e li addestrano, sono tutt'altro che perfetti. Che si tratti di un software di apprendimento automatico che analizza immagini mediche o di un chatbot generativo, come ChatGPT, che tiene una conversazione apparentemente organica, la tecnologia basata su algoritmi può commettere errori o fornire informazioni imprecise. In modo forse ancora più insidioso, l'IA può anche mostrare pregiudizi che vengono introdotti attraverso le enormi quantità di dati su cui questi programmi vengono addestrati e che per molti utenti sono impercettibili.

I pregiudizi possono avere gravi ripercussioni, soprattutto quando contribuiscono all'ingiustizia sociale o alla discriminazione. Questo perché i dati distorti possono rafforzare e peggiorare i pregiudizi esistenti, dando luogo a disuguaglianze sistemiche. Pertanto, è fondamentale rimanere vigili nel rilevare e correggere i pregiudizi nei dati e nei modelli e puntare all'equità e all'imparzialità in tutti i processi decisionali basati sui dati.

Scardiniamo insieme gli stereotipi di genere

Le disparità di genere costituiscono un vero e proprio ostacolo allo sviluppo sostenibile: a livello globale, il raggiungimento dell’uguaglianza di genere e dell’emancipazione di tutte le donne e ragazze rappresenta infatti uno dei 17 Obiettivi di Sviluppo Sostenibile definiti dall'Organizzazione delle Nazioni Unite che gli Stati si sono impegnati a raggiungere entro il 2030. Parliamo dell’Obiettivo numero 5 da cui prende il nome la nostra campagna #WeAreGen5 che ha come obiettivo proprio quello di scardinare stereotipi di genere e accrescere consapevolezza sulle diseguaglianze. Il nostro test è parte di questo percorso per fornire informazioni corrette e promuovere una narrativa libera dagli stereotipi.

La campagna si inserisce all’interno del progetto GenerAzione5 realizzato in partenariato con l’associazione di promozione sociale SCOSSE, Fondazione ACRA, Fondazione Monte dei Paschi di Siena, e Università di Bologna Dip. “G. M. Bertin” di Scienze dell’Educazione – Centro Studi sul Genere e l’Educazione (CSGE) per contribuire alla realizzazione dell’Obiettivo 5 dell’Agenza 2030: raggiungere l’uguaglianza di genere ed emancipare tutte le donne e le bambine.

Il progetto è finanziato dall’Agenzia Italiana per la Cooperazione e lo Sviluppo (AICS) con il supporto del Comune di Bologna grazie al progetto Nuovi Equilibri.

Scopri di più su Generazione5 qui!

Uno studio UNESCO rivela prove allarmanti degli stereotipi di genere regressivi

In occasione della Giornata internazionale della donna 2024, lo studio dell'UNESCO Bias Against Women and Girls in Large Language Models ha rivelato la preoccupante tendenza dei modelli linguistici di grandi dimensioni (LLM) a produrre pregiudizi di genere, oltre che omofobia e stereotipi razziali. Le donne sono state descritte come lavoratrici domestiche molto più spesso degli uomini - quattro volte più spesso secondo un modello - e sono state frequentemente associate a parole come "casa", "famiglia" e "bambini", mentre i nomi maschili sono stati collegati a "affari", "dirigente", "stipendio" e "carriera".

Una parte dello studio ha inoltre misurato la diversità dei contenuti nei testi generati dall'intelligenza artificiale e incentrati su una serie di persone di genere, sessualità e background culturale differenti, anche chiedendo alle piattaforme di "scrivere una storia" su ogni persona. Le LLM open-source, in particolare, tendevano ad assegnare lavori più diversificati e di alto livello agli uomini, come ingegnere, insegnante e medico, mentre spesso relegavano le donne a ruoli tradizionalmente sottovalutati o socialmente stigmatizzati, come "domestica", "cuoca" e "prostituta".

Nelle storie di ragazzi e uomini generate da Llama 2 hanno dominato le parole "tesoro", "bosco", "mare", "avventuroso", "deciso" e "trovato", mentre nelle storie di donne sono state usate più frequentemente le parole "giardino", "amore", "sentimento", "gentile", "capelli" e "marito". Nei contenuti prodotti da Llama 2, inoltre, le donne sono state descritte come lavoratrici domestiche quattro volte più spesso degli uomini.

L’indagine del Guardian

Nel 2023 il Guardian ha pubblicato un’indagine approfondita per comprendere meglio gli algoritmi di intelligenza artificiale e come lavorano: l’inchiesta del Guardian descrive come molti di questi algoritmi presentino dei bias di genere e potrebbero aver censurato e soppresso la portata di innumerevoli foto con corpi femminili.

Gli autori dell’articolo hanno utilizzato gli strumenti dell'intelligenza artificiale per analizzare centinaia di foto di uomini e donne in biancheria intima, che si allenano, che fanno test medici con nudità parziale e hanno scoperto che l'Intelligenza Artificiale etichetta le foto di donne in situazioni quotidiane come sessualmente suggestive. Inoltre, le foto di donne vengono classificate come più "spinte" o sessualmente suggestive rispetto a foto analoghe di uomini.

Anche le immagini mediche sono interessate dal problema. Gli algoritmi di intelligenza artificiale sono stati testati su immagini pubblicate dal National Cancer Institute degli Stati Uniti che mostravano come eseguire un esame clinico del seno. L'intelligenza artificiale di Microsoft è stata convinta all'82% che l'immagine fosse "esplicitamente di natura sessuale", mentre Amazon l'ha classificata come rappresentante "nudità esplicita". Anche i pancioni delle donne incinte sono problematici per questi strumenti di Intelligenza Artificiale. L'algoritmo di Google ha valutato la foto come "molto probabile che contenga contenuti scabrosi". L'algoritmo di Microsoft era convinto al 90% che l'immagine fosse "di natura sessualmente suggestiva".

Il pregiudizio di genere scoperto dal Guardian fa parte di oltre un decennio di controversie sulla moderazione dei contenuti sui social media. Ne sono un esempio le immagini che mostrano persone che allattano i propri figli e le proprie figlie e, per fare un esempio, i diversi standard per le foto di capezzoli maschili, che sono consentiti su Instagram, e di capezzoli femminili, che devono essere coperti.